White Paper: Virtualisierung

Server Virtualisierung und Monitoring

Einführung

Server-Virtualisierung hat sich immer wieder als effizienteste Form bei der Virtualisierung von Rechenzentren bewährt. Trotz der sich allmählich zeigenden Grenzen der Server-Virtualisierung hat sie nach wie vor enorme, positive Auswirkungen auf Betriebs- und Kühlkosten sowie auf Rechenzentrumskapazitäten. Sie kann die Lebensdauer alternder Rechenzentren verlängern und es einigen großen Organisationen sogar ermöglichen, komplette Rechenzentren einzusparen.

Virtualisierung heute

Aktuelle Technologie macht es möglich, dass sich mehrere virtuelle Hosts eine einzige Betriebssystemlizenz teilen. Das kann so weit gehen, dass zwischen 50 und 100 virtuelle Server auf einer einzigen physischen Maschine laufen, die so eine große Anzahl von rechenintensiven Anwendungen verwalten, was im Bereich der Virtualisierung noch vor fünf Jahren als unmöglich galt.

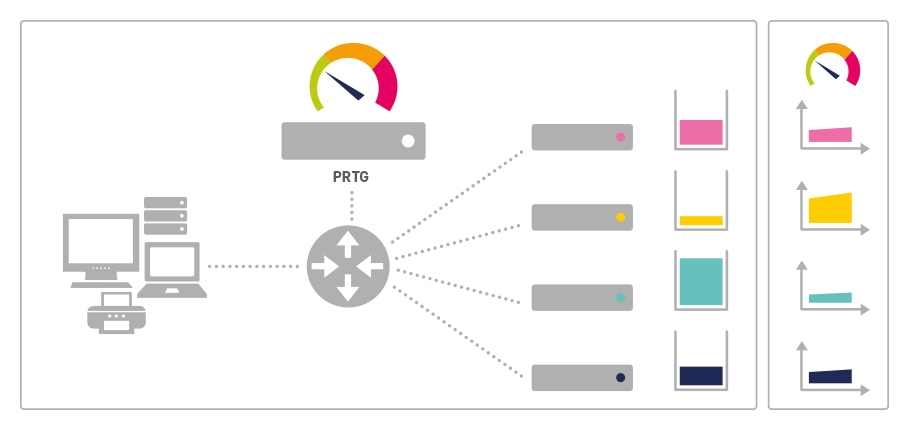

ABBILDUNG: Jede Applikation ist auf

einem eigenen physikalischen

Server mit angeschlossenem

Speicher beheimatet

Virtualisierung funktioniert, indem Anwendungen aus der begrenzten und starren Umgebung eines einzelnen physischen Servers losgelöst werden. So können mehrere Anwendungshosts auf einem Server laufen und – was gleichermaßen wichtig ist – es ermöglicht einer Anwendung auch, Ressourcen über das Firmennetzwerk zu nutzen. Eines der Merkmale der Virtualisierung ist die Möglichkeit, Anwendungen oder Gäste dynamisch von einem physischen Server zu einem anderen zu bewegen, sobald sich die Anforderungen und Ressourcenverfügbarkeiten ändern, und das ohne Betriebsunterbrechung. Darüber hinaus können Sie jetzt auch Ressourcen wie CPU, Arbeitsspeicher und Disks zu einer virtualisierten Maschine on-the-fly hinzufügen, auch ohne Serviceunterbrechung.

Virtualisierung beinhaltet ebenfalls die Nutzung von Storage Area Networks (SANs) und freistehendem Speicher. Damit rückt das Netzwerk weiter in den Mittelpunkt der IT-Infrastruktur und -Architektur. Vom Sicherheitsstandpunkt aus birgt die Zentralisierung mehrerer Anwendungen auf einem einzigen System allerdings Fehlerquellen, sowohl im physischen Server selbst als auch in der Netzwerkverbindung. Wenn ein virtualisierter Server abstürzt, seine Netzwerkverbindung verlangsamt oder abbricht, wirkt sich dies auf alle Anwendungen in diesem Umfeld aus. Allerdings gibt es inzwischen viele Software-Tools, die sich auf virtualisierte Server-Hochverfügbarkeit spezialisiert haben. Von der inkrementellen Sicherung bis hin zur vollständigen virtuellen Server-Replikation zu einer Backup-Site, die mit sehr geringer Wiederherstellungszeit wieder online gebracht werden kann.

Die Rolle des Netzwerks für die Virtualisierung

Wichtig für die Netzwerkplanung ist, dass sich weitaus mehr Datenverkehr auf einigen großen Servern bündelt, anstatt sich über eine große Anzahl kleinerer Computer im Rechenzentrum zu verteilen. Auch Virtualisierung funktioniert am besten mit unabhängigem anstatt lokalem Speicher. Dies erfordert eine sehr schnelle und zuverlässige Netzwerkkonnektivität zwischen Servern und den Speichergeräten im SAN (Storage Area Network). Unternehmen, die sich von lokalem Speicher verabschieden, werden im Zuge der Virtualisierung einen starken Anstieg des Netzwerkverkehrs bemerken. Auch die für diese Netze verwendeten Medien können bei der Betrachtung von Fibre-Channel-Verbindungen, die weit über 10 Gbit/s Bandbreite erlauben, kostspielig sein.

All dies erhöht die Notwendigkeit eines durchdachten Netzwerkmanagements.

Eine hochvirtualisierte Umgebung steht und fällt mit der Effizienz und Zuverlässigkeit ihres Datennetzes. Das Versagen eines physischen Servers, einer Verbindung, eines Switches oder eines Routers kann sehr kostspielig sein, wenn es z. B. Wissensarbeiter, automatisierte Fabrikböden oder Online-Einzelhandelsoperationen von lebenswichtiger IT-Funktionalität trennt. Das Netzwerkmanagement kann wichtige Informationen für die Planung und das Testen virtualisierter Umgebungen liefern. Zum Beispiel ist die Bestimmung, welche Anwendungen sich nicht für die Virtualisierung eignen, von entscheidender Bedeutung. Die Menge und Art des Netzwerkverkehrs kann wichtige Hinweise zur Identifizierung dieser Anwendungen liefern.

Warum Server-Virtualisierung

Die Server-Virtualisierung ermöglicht IT-Abteilungen, diese Ziele zu erreichen – trotz des Drucks, die Kosten der überlasteten Rechenzentren angesichts einer weltweit wachsenden Rezession senken zu müssen aufgrund stetig steigender Energiekosten. Virtualisierung greift das Problem der geringen Auslastung einzelner Anwendungsserver an, die sich in Rechenzentren mittlerer bis sehr großer Unternehmen befinden. Die Serverpopulationen vieler nicht virtualisierter Umgebungen sind durchschnittlich nur zu etwa 20% ausgelastet. Die Folge ist eine riesige Verschwendung von Strom, die sich verdoppelt, da jedes verwendete Kilowatt mit einer gleichen Kühlung ausgeglichen werden muss, um die Server auf optimale Betriebstemperatur zu halten.

Dies hat auch gravierende Folgen auf die Lebensdauer von Rechenzentren, da mehr und mehr Anlagen unter Strom- und Raumknappheit sowie Kühlungsproblemen leiden, obwohl sie in den vergangenen Jahren auf Blade-Server umgestellt wurden. Probleme sind auch vermehrt auftretende Naturkatastrophen, wenn Rechenzentren überschwemmt werden und dann keine zuverlässige Backup-Leistung liefern. Virtualisierung vermeidet diese Ausfälle durch das automatische Ablegen von mehreren Anwendungen auf einem einzigen Server und die gemeinsame Nutzung von Ressourcen.

Die genannten Einsparungen werden unter anderem durch den Einsatz der sogenannten Hypervisor Technologie bei der Virtualisierung erreicht, die von den Produkten VMWare Server, Microsoft Virtual Server, XenServer und vergleichbaren Produkten eingesetzt wird. Der Hypervisor erfordert, dass jeder virtuelle Server über eine eigene Kopie des Betriebssystems verfügt. Dies ist die bevorzugte Lösung, wenn Anwendungen, die auf unterschiedlichen Betriebssystemen laufen - beispielsweise Windows, Unix oder Linux - als virtualisierte Anwendungen auf einem physikalischen Rechner betrieben werden sollen, d. h. jeder virtuelle Rechner denkt, er hätte die Hardware für sich alleine.

Wenn aber verschiedene Applikationen, die unter dem gleichen Betriebssystem laufen, virtualisiert werden sollen, gibt es effizientere Lösungen. In diesem Fall bietet die Virtualisierung von Applikationen (im Gegensatz zur Server Virtualisierung) eine deutlich effizientere Lösung, indem Sie mehreren virtuellen Anwendungen die Nutzung einer einzigen Kopie des Betriebssystems ermöglicht (z.B. mit Virtuozzo, OpenVZ). Je nach Applikation können so auch hochperformante Applikationen virtualisiert werden, die sich für eine Virtuali-sierung mittels Hypervisor Technik nicht eignen.

Einsparung von $ 2,4 Millionen Energiekosten pro Jahr – das Beispiel BT

Durch die gemeinsame Ressourcennutzung können IT-Shops ihre Serverauslastung bis zu 80 % erhöhen. Die Auswirkungen auf eine große Organisation werden im Folgenden anhand der Erfahrungen des Unternehmens BT in Großbritannien aufgezeigt. BT erreichte eine 15:1-Konsolidierung seiner 3.000 Wintel-Server und sparte etwa 2 Megawatt Leistung und 2,4 Millionen US-Dollar an jährlichen Energiekosten ein. Dadurch sanken die Wartungskosten der Server um 90 %, BT schaffte 225 Tonnen Hardware (umweltfreundlich) ab und schloss mehrere Rechenzentren in ganz Großbritannien. Diese Einsparung ist noch bemerkenswerter, weil es nur die Wintel-Server betrifft – BT betreibt auch eine große Anzahl von Unix-Servern, die nicht in die Einsparungen einbezogen wurden.

BT konnte nicht nur große Einsparungen erzielen, weil man kein neues Rechenzentrum für geschätzte 120 Millionen Dollar bauen musste. Das Unternehmen erhielt darüber hinaus drei der angesehensten europäischen Ökologie-Auszeichnungen für die Reduzierung der CO2-Belastung. Während dieses Prozesses wuchsen BTs Geschäfte beständig, was das weit verbreitete Argument Lügen straft, dass Firmen und Nationen lediglich die Wahl haben, entweder ihre Wirtschaft anzukurbeln oder die Umweltauswirkungen möglichst gering zu halten. BT war weit davon entfernt, sein Geschäft zu vernachlässigen, vielmehr gewann BT im Bereich „Green Business“ sowohl in der Europäischen Union als auch in den Vereinigten Staaten immens an Glaubwürdigkeit.

BT ist nicht einmal ein extremes Beispiel dafür, was erreicht werden kann. Natürlich ist BT ein sehr großes Unternehmen. Kleinere Firmen erzielen proportional kleinere Einsparungen, aber die Prozentzahlen werden Unternehmen mit Serverkapazitäten von 50 und mehr durchaus entsprechen. Damit können sie die effektive Lebenszeit ihrer Rechenzentren verlängern und Energiekosten sparen. Auch kleinere Unternehmen profitieren von Virtualisierung, vor allem wenn es nötig wird, seine Server zu aktualisieren. Es ist viel leichter, einen großen Server zu kaufen, zu betreiben und zu pflegen als mehrere kleine. Durch das automatisierte Applikationsmanagement, das die Virtualisierung bietet, kann eine kleinere Firma einen oder sogar mehrere Vollzeit-IT-Mitarbeiter einsparen.

Virtualisierung von Anwendungen

Diese Einsparungen erreicht man vor allem durch Hypervisor-Virtualisierung, wie sie von VMware, Hyper-V und anderen Anbietern angeboten wird. Bei dieser Technologie muss jeder virtuelle Host seine eigene Kopie des Betriebssystems ausführen. Dies ist die bevorzugte Lösung, wenn Anwendungen verschiedener Betriebssysteme – zum Beispiel eine Mischung aus Windows, Unix und Linux oder mehrere verschiedene Unix-Systeme – auf einem einzigen physischen Server virtualisiert werden. Die Virtualisierung vieler Anwendungen auf demselben Betriebssystem hat jedoch Auswirkungen auf die Effizienz.

Der aufkommende neue Ansatz der „Application Virtualization“ (Anwendungsvirtualisierung) bietet in diesen Fällen eine effizientere Lösung: Hier teilen sich mehrere virtualisierte Anwendungen eine einzelne Kopie eines Betriebssystems. So können nicht nur mehrere Anwendungen parallel auf einem physischen Server laufen, sondern es wird nach Meinung der Befürworter auch ein effizienterer Betrieb von rechenintensiven Applikationen möglich sein, die normalerweise nicht für Hypervisor-Virtualisierung geeignet sind.

Unified Monitoring und Virtualisierung

Auf den ersten Blick scheint Virtualisierung selbst wenig Einfluss auf die einheitliche Überwachung (Unified Monitoring) zu haben. Die gleichen Anwendungen laufen im gleichen Rechenzentrum, nur auf einer anderen Hardware. Bei genauerem Hinsehen hat das Unified Monitoring jedoch durchaus seine Auswirkungen. Deren Ausmaß variiert je nach Ausgangs-IT-Architektur. Virtualisierung wird das Netzwerk ins Zentrum der IT-Infrastruktur rücken und die alte Architektur von 40 physischen Servern in einem Rack ablösen. Dadurch erhöht sich die Bedeutung des Netzwerkbetriebs und die potenziellen Auswirkungen von Unterbrechungen, sodass eine starke, einheitliche Überwachung entscheidend für das heutige Geschäft ist.

Wie Virtualisierung funktioniert

Konzentration der Anwendungen

Zum einen zentralisiert die Virtualisierung Anwendungen auf einem oder vergleichsweise wenigen physischen Servern, wodurch diese und letztendlich deren Netzwerkverbindungen zu geschäftsschädigenden Ausfallursachen (Single Points of Failure) werden können. Wer sich noch an die Green-Screen-Operationen der 1980er-Jahre erinnert, weiß: Sobald der Zentralrechner stand, mussten alle Arbeiten im Büro gestoppt werden. Der Ausfall eines Netzwerk-Switches oder -Routers in einer hochvirtualisierten Umgebung könnte einen ähnlichen Einfluss haben, wenn der Zugriff auf 50-100 wichtige Anwendungen unmöglich wird. Ein einheitliches Monitoring-Tool wie Paesslers PRTG Network Monitor bietet sofortige Benachrichtigungen bei jeglicher Art von Fehlern auf dem Virtualisierungs-Host, -Gastsystem und den Anwendungen des Gastes, die darauf ausgeführt werden. Damit kann die IT sofortige Maßnahmen ergreifen, um die Auswirkungen des Fehlers zu minimieren.

Speicherlösungen und Virtualisierung

Ein Vorteil der Servervirtualisierung ist, dass Ressourcen, einschließlich Speicherplatz, dynamisch von einer Anwendung zur anderen verteilt und verschoben werden können. In einer Multi-Server-Umgebung bedeutet dies die Migration von direktem, angeschlossenem Speicher (bei dem die Festplatten direkt mit dem Server verbunden sind) zu getrennten Speichersystemen, die auf einem Storage Area Network (SAN) laufen, das Teil der gesamten Netzwerkinfrastruktur wird. Diese Migration geht seit den späten 1990er-Jahren vonstatten und hat mehrere Vorteile in Bezug auf Flexibilität und Datenschutz. Dieser Vorgang wird sich weiter beschleunigen, da sich die Servervirtualisierung auch in den Rechenzentren durchsetzen wird, die immer noch direkt angeschlossenen Serverspeicher verwenden.

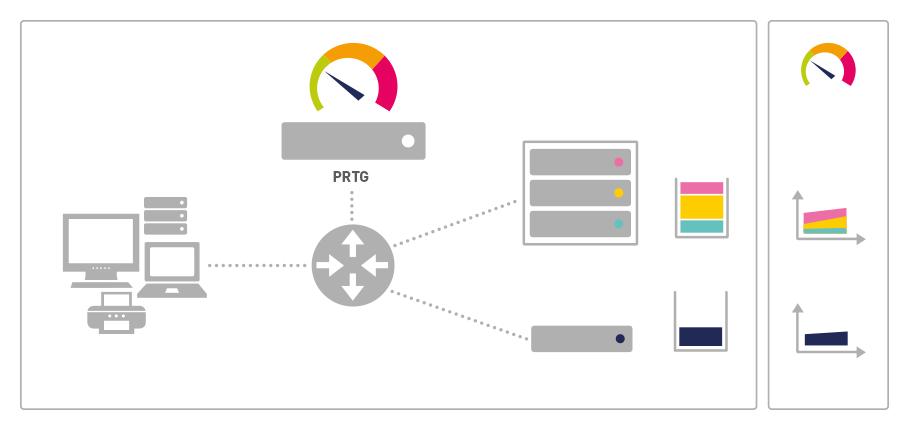

ABBILDUNG: Drei Anwendungen laufen

in einer virtuellen Umgebung

und teilen sich die Ressourcen

des virtuellen Servers

Der Nachteil ist, dass der gesamte Zugriff zwischen Anwendungen und Daten nun über ein Netzwerk laufen muss und sogar kleine Verzögerungen bei vielen Applikationen Probleme verursachen können. Virtualisierte Umgebungen tolerieren beispielsweise keine Netzwerküberlastungen oder Switch-Ausfälle. Deshalb ist ein ausgefeiltes Netzwerkmanagement vonnöten.

Ein starkes, einheitliches Monitoring-Tool wie Paesslers PRTG Network Monitor bietet Echtzeit-Überwachung des Traffics an kritischen Punkten im Netzwerk sowie langfristige Nutzungsprognosen. Dies hilft Ihnen als IT-Administrator, hohe Traffic-Aufkommen abzufangen, bevor sie zu Problemen führen. Sie können Ihre Speichernetzwerke getrennt von Ihren Produktionsnetzwerken überwachen und die Auswirkungen aufeinander abbilden. Sie erhalten somit immer die nötigen Informationen, wenn es darum geht, wesentliche Infrastrukturbereiche upzugraden, die diese beiden Netzwerke miteinander verbinden.

Ungeeignete Anwendungen für die Virtualisierung

Es gibt immer Anwendungen, die ihre Ressourcen am besten von einem dedizierten Host erhalten. Auch bei PRTG empfehlen wir Ihnen, einen dedizierten Host für Applikationen über 5.000 Sensoren zu verwenden. Allerdings wird die Liste der nicht geeigneten Anwendungen immer kürzer, da sich die Technologie stetig weiterentwickelt. Welche Anwendungen auf dedizierten Servern bleiben sollten, ist nicht immer leicht herauszufinden. Das Volumen und die Art der Übertragungen zu und von diesen Anwendungen bieten wichtige Hinweise auf die Identifizierung geeigneter Applikationen und ein starkes Unified Monitoring Tool wie PRTG Network Monitor ist die beste Quelle für diese wichtige Information. Ob es sich um hohe CPU-Auslastung oder Warteschlangen handelt, hohe Festplatten-I/O- oder Compliance-Aufgaben, PRTG kann Ihnen helfen, diese einzigartigen Anforderungen zu identifizieren. Damit erleichtern Sie sich die Entscheidung, welche Anwendungen einen dedizierten Host benötigen und welche nicht.

Virtualisierungen und Ressourcenverwaltung

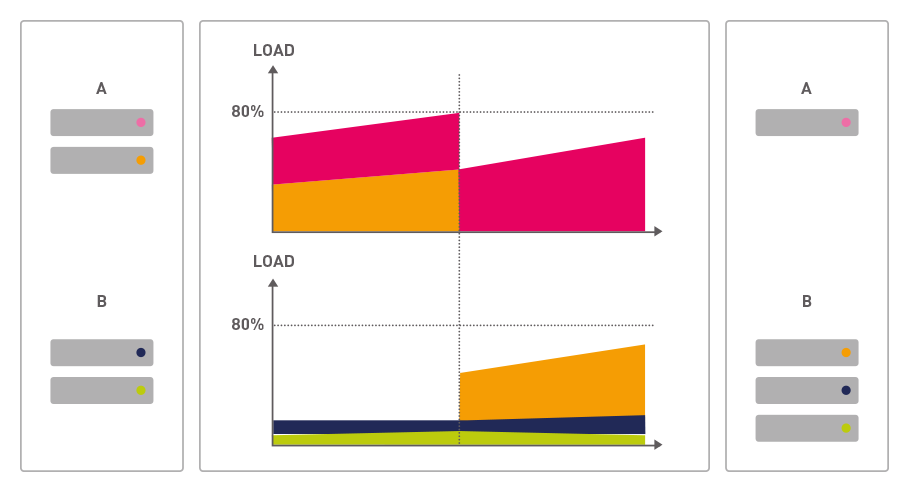

Server-Virtualisierung verspricht eine dynamische Neuzuordnung von zugrundeliegenden Berechnungs-, Arbeitsspeicher- und Speicherressourcen, um Lastspitzen auf einzelne Anwendungen abzudecken. Dies ist der eigentliche Schlüssel zur Effizienzsteigerung bei der Ressourcenallokation. Ein wichtiger Grund dafür, dass nicht virtualisierte Umgebungen eine so geringe Auslastung aufweisen, ist, dass jede Anwendung genügend Computerleistung und Speicher benötigt im Falle von Lastspitzen sowie einen Overhead für zukünftiges Wachstum. Es ist oft jedoch schwierig, die Geschwindigkeit des Wachstums vorherzusagen: Beispielsweise ist die Systemauslastung gering, wenn User sich in eine neue Applikation einarbeiten, und steigt dann sprunghaft an, sobald sie sich auskennen und das volle Potenzial des Programms ausreizen. Oft unterliegt die Auslastung vieler Anwendungen großen zyklischen Schwankungen, weil sie etwa nur wöchentlich, monatlich oder jährlich intensiv genutzt werden. Finanzabteilungen mit ihren monatlichen oder vierteljährlichen Abrechnungen/Berichten sind das beste Beispiel dafür, aber es gibt viele weitere.

ABBILDUNG: Mit wachsender Akzeptanz

einer Anwendung durch die

Nutzer (rot) benötigt diese

verstärkt Ressourcen. Dies

kann an Punkt tx einfach durch

Verschieben einer anderen App-

likation (blau) auf eine andere

virtuelle Maschine erreicht werden

Noch einmal sei betont, dass in einer nicht virtualisierten Umgebung jede Anwendung genügend Rechenressourcen haben muss, um versprochene Service-Level unter der maximalen jährlichen Last einzuhalten. Für einige Anwendungen bedeutet dies eine große Investition in Rechenressourcen, obwohl sie die meiste Zeit kaum benutzt werden. Virtualisierung beseitigt dieses Problem dank der dynamischen Zuweisung von Computerressourcen. Die verschiedenen Applikationen, die in einem Rechenzentrum laufen, können in unterschiedlichen Anforderungszyklen betrieben werden. Eine Anwendung, die zu einem bestimmten Zeitpunkt einen Anstieg der Auslastung erfährt, kann sich die Ressourcen von einer anderen, weniger ausgelasteten „ausleihen“. Anbieter von Virtualisierungslösungen versprechen für den Extremfall sogar, eine gesamte Applikation über das Netzwerk dynamisch von einem Server zum anderen umzuleiten, um auf solche Auslastungsspitzen zu reagieren. Letztlich bedeutet dies, dass alle Server und Speichergeräte innerhalb einer virtualisierten Umgebung wie eine große Maschine behandelt werden können. Ihre Ressourcen werden zusammengefasst, um die Gesamtauslastung aller virtualisierten Software abzufangen, die auf dieser Maschine läuft.

In der Praxis wird dies nur innerhalb eines Rechenzentrums funktionieren, da Übertragungsverzögerungen zwischen mehreren Zentren zu Leistungsproblemen führen könnten. Essentielle Voraussetzung hierbei ist, dass das Netzwerk, das diese physischen Server verbindet, schnell und höchst fehlertolerant ist. Um diese Leistung zu garantieren, ist ein hohes Maß an Netzwerkmanagement erforderlich.